— Microsoft, Dell Technologies, HPE, Lenovo, Meta, Oracle, Supermicro, dan lainnya mengadopsi akselerator AI data center AMD Instinct MI300X dan MI300A baru untuk solusi pelatihan dan inferensi —

— AMD juga meluncurkan tumpukan sofware ROCm 6 dengan optimalisasi kinerja yang signifikan dan fitur-fitur baru untuk Large Language Models dan prosesor notebook Ryzen 8040 Series untuk PC AI —

SAN JOSE, California — 6 Desember 2023 — Hari ini dalam acara “Advancing AI”, AMD (NASDAQ: AMD) bergabung dengan para pemimpin industri termasuk Microsoft, Meta, Oracle, Dell Technologies, HPE, Lenovo, Supermicro, Arista, Broadcom dan Cisco untuk menunjukkan bagaimana perusahaan-perusahaan ini bekerja dengan AMD untuk menghadirkan solusi AI canggih mulai dari cloud hingga perusahaan dan PC. AMD meluncurkan beberapa produk baru di acara tersebut, termasuk akselerator AI data center AMD Instinct™ MI300 Series, tumpukan open software ROCm™ 6 dengan optimalisasi signifikan, dan fitur-fitur baru yang mendukung Large Language Models (LLM) dan prosesor Ryzen™ 8040 Series dengan Ryzen AI.

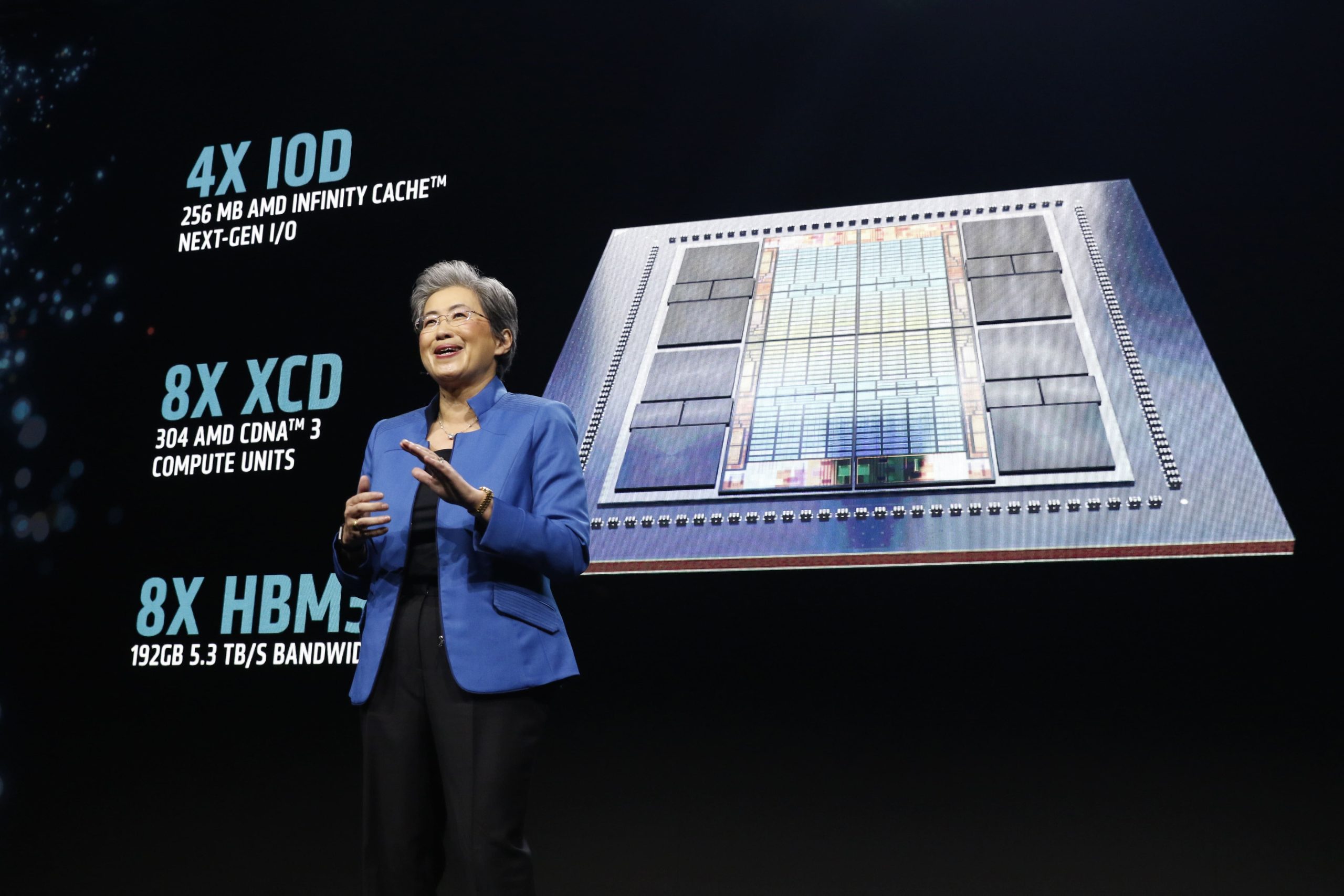

“AI adalah masa depan komputasi dan AMD secara unik diposisikan untuk mendukung infrastruktur end-to-end yang akan menentukan era AI ini, mulai dari instalasi cloud besar-besaran hingga klaster perusahaan serta perangkat dan PC tertanam cerdas yang didukung AI,” ucap AMD Chair and CEO Dr. Lisa Su. “Kami melihat permintaan yang sangat tinggi terhadap GPU Instinct MI300 baru kami, yang merupakan akselerator performa tertinggi di dunia untuk AI generatif. Kami juga membangun momentum yang signifikan untuk solusi AI data center kami dengan perusahaan cloud terbesar, penyedia server terkemuka di industri, dan startup AI paling inovatif ꟷ yang bekerja sama dengan kami untuk segera menghadirkan solusi Instinct MI300 ke pasar yang akan mempercepat pertumbuhan secara signifikan. kecepatan inovasi di seluruh ekosistem AI[i].”

Memajukan AI Data Center dari Cloud ke Data Center Perusahaan dan Superkomputer

AMD bergabung dengan beberapa mitra selama acara tersebut untuk menyoroti adopsi yang kuat dan momentum pertumbuhan akselerator AI data center AMD Instinct.

- Microsoft merinci bagaimana mereka menerapkan akselerator AMD Instinct MI300X untuk mendukung seri Virtual Machine (VM) Azure ND MI300x v5 baru yang dioptimalkan untuk beban kerja AI.

- Meta menyampaikan bahwa perusahaan menambahkan akselerator AMD Instinct MI300X ke data center mereka yang dikombinasikan dengan ROCm 6 untuk mendukung beban kerja inferensi AI dan mengakui optimalisasi ROCm 6 yang telah dilakukan AMD pada rangkaian model Llama 2.

- Oracle mengumumkan rencana untuk menawarkan solusi komputasi bare metal OCI yang dilengkapi akselerator AMD Instinct MI300X serta rencana untuk menyertakan akselerator AMD Instinct MI300X dalam layanan AI generatif mereka yang akan datang.

- Penyedia infrastruktur data center terbesar mengumumkan rencana untuk mengintegrasikan akselerator AMD Instinct MI300 ke dalam portofolio produk mereka. Dell mengumumkan integrasi akselerator AMD Instinct MI300X dengan solusi server PowerEdge XE9680 untuk menghadirkan kinerja inovatif untuk beban kerja AI generatif dalam format modular dan terukur bagi pelanggan. HPE mengumumkan rencana untuk menghadirkan akselerator AMD Instinct MI300 ke dalam penawaran perusahaan dan HPC. Lenovo menyampaikan rencana untuk menghadirkan akselerator AMD Instinct MI300X ke platform Lenovo ThinkSystem untuk menghadirkan solusi AI di seluruh industri termasuk ritel, manufaktur, layanan keuangan, dan perawatan kesehatan. Supermicro mengumumkan rencana untuk menawarkan GPU AMD Instinct MI300 di seluruh portofolio solusi AI mereka. Asus, Gigabyte, Ingrasys, Inventec, QCT, Wistron dan Wiwynn juga berencana menawarkan solusi yang didukung oleh akselerator AMD Instinct MI300.

- Penyedia cloud AI khusus termasuk Aligned, Arkon Energy, Cirrascale, Crusoe, Denvr Dataworks, dan Tensorwaves semuanya berencana memberikan penawaran yang akan memperluas akses ke GPU AMD Instinct MI300X untuk pengembang dan startup AI.

Menghadirkan Platform Software AI yang Terbuka, Handal, dan Siap Pasar

AMD menyoroti kemajuan signifikan dalam memperluas ekosistem software yang mendukung akselerator data center AMD Instinct.

- AMD meluncurkan versi terbaru dari tumpukan software open source untuk GPU AMD Instinct, ROCm 6, yang telah dioptimalkan untuk AI generatif, khususnya large language model. ROCm 6 menawarkan dukungan untuk tipe data baru, grafik tingkat lanjut dan optimasi kernel, perpustakaan yang dioptimalkan dan algoritma perhatian canggih, yang bersama-sama dengan MI300X memberikan peningkatan kinerja ~8x untuk latensi keseluruhan dalam pembuatan teks pada Llama 2 dibandingkan dengan ROCm 5 yang berjalan pada MI250.[ii]

- Databricks, Essential AI dan Lamini, tiga startup AI yang membangun model dan solusi AI baru, bergabung dengan AMD di atas panggung untuk membahas bagaimana mereka memanfaatkan akselerator AMD Instinct MI300X dan rangkaian software open ROCm 6 untuk menghadirkan solusi AI yang berbeda bagi pelanggan perusahaan.

- OpenAI menambahkan dukungan untuk akselerator AMD Instinct ke Triton 3.0, memberikan dukungan out-of-the-box untuk akselerator AMD yang memungkinkan pengembang bekerja pada tingkat abstraksi yang lebih tinggi pada hardware AMD.

Baca di sini untuk informasi lebih lanjut tentang akselerator AMD Instinct MI300 Series, ROCm 6, dan ekosistem solusi AI bertenaga AMD yang sedang berkembang.

Kepemimpinan yang Berkelanjutan dalam Memajukan PC AI

Dengan jutaan PC AI yang dikirimkan hingga saat ini, AMD mengumumkan kepemimpinan prosesor mobile baru dengan peluncuran prosesor AMD Ryzen 8040 Series terbaru yang menghadirkan kemampuan komputasi AI yang lebih baik lagi. AMD juga meluncurkan Software Ryzen AI 1.0, tumpukan software yang memungkinkan pengembang dengan mudah menerapkan aplikasi yang menggunakan model terlatih guna menambahkan kemampuan AI untuk aplikasi Windows. AMD juga mengungkapkan bahwa CPU “Strix Point” generasi berikutnya, yang direncanakan diluncurkan pada tahun 2024, akan menyertakan arsitektur XDNA™ 2 untuk memberikan peningkatan kinerja komputasi AI lebih dari 3x dibandingkan generasi sebelumnya[iii] yang akan memungkinkan pengalaman AI generatif baru. Microsoft juga bergabung untuk membahas bagaimana mereka bekerja sama dengan AMD dalam pengalaman AI masa depan untuk PC Windows.

[i] Measurements conducted by AMD Performance Labs as of November 11th, 2023 on the AMD Instinct™ MI300X (750W) GPU designed with AMD CDNA™ 3 5nm | 6nm FinFET process technology at 2,100 MHz peak boost engine clock resulted in 163.4 TFLOPs peak theoretical double precision Matrix (FP64 Matrix), 81.7 TFLOPs peak theoretical double precision (FP64), 163.4 TFLOPs peak theoretical single precision Matrix (FP32 Matrix), 163.4 TFLOPs peak theoretical single precision (FP32), 653.7 TFLOPS peak theoretical TensorFloat-32 (TF32), 1307.4 TFLOPS peak theoretical half precision (FP16), 1307.4 TFLOPS peak theoretical Bfloat16 format precision (BF16), 2614.9 TFLOPS peak theoretical 8-bit precision (FP8), 2614.9 TOPs INT8 floating-point performance.

Published results on Nvidia H100 SXM (80GB) GPU resulted in 66.9 TFLOPs peak theoretical double precision tensor (FP64 Tensor), 33.5 TFLOPs peak theoretical double precision (FP64), 66.9 TFLOPs peak theoretical single precision (FP32), 494.7 TFLOPs peak TensorFloat-32 (TF32)*, 989.4 TFLOPS peak theoretical half precision tensor (FP16 Tensor), 133.8 TFLOPS peak theoretical half precision (FP16), 989.4 TFLOPS peak theoretical Bfloat16 tensor format precision (BF16 Tensor), 133.8 TFLOPS peak theoretical Bfloat16 format precision (BF16), 1,978.9 TFLOPS peak theoretical 8-bit precision (FP8), 1,978.9 TOPs peak theoretical INT8 floating-point performance.

Nvidia H100 source:

https://resources.nvidia.com/en-us-tensor-core/

* Nvidia H100 GPUs don’t support FP32 Tensor.

MI300-18

[ii] Text generated with Llama2-70b chat using input sequence length of 4096 and 32 output token comparison using custom docker container for each system based on AMD internal testing as of 11/17/2023. Configurations: 2P Intel Xeon Platinum CPU server using 4x AMD Instinct™ MI300X (192GB, 750W) GPUs, ROCm® 6.0 pre-release, PyTorch 2.2.0, vLLM for ROCm, Ubuntu® 22.04.2. Vs. 2P AMD EPYC 7763 CPU server using 4x AMD Instinct™ MI250 (128 GB HBM2e, 560W) GPUs, ROCm® 5.4.3, PyTorch 2.0.0., HuggingFace Transformers 4.35.0, Ubuntu 22.04.6.

4 GPUs on each system was used in this test. Server manufacturers may vary configurations, yielding different results. Performance may vary based on use of latest drivers and optimizations. MI300-33

[iii] An AMD Ryzen “Strix point” processor is projected to offer 3x faster NPU performance for AI workloads when compared to an AMD Ryzen 7040 series processor. Performance projection by AMD engineering staff. Engineering projections are not a guarantee of final performance. Specific projections are based on reference design platforms and are subject to change when final products are released in market. STX-01.